Windows 本地部署 DeepSeek 蒸馏版本

DeepSeek 作为一款国运级别的AI大模型,其优势在于平衡了成本和性能,让中小公司,甚至个人能够落地本地私有化部署AI大模型。

本地部署的 DeepSeek 蒸馏版本,肯定不能和满血版的对比,本地部署的优势在于数据的安全性,和模型的可控。

在特定的场景下,本地部署的 DeepSeek 也足以胜任工作。

一、Ollama 介绍

Ollama 介绍只有一句话: Get up and running with large language models。

获得和运行大语言模型。

Ollama 屏蔽了运行大语言模型的复杂性,主要安装 Ollama 就能够简单快速的运行大语言模型。

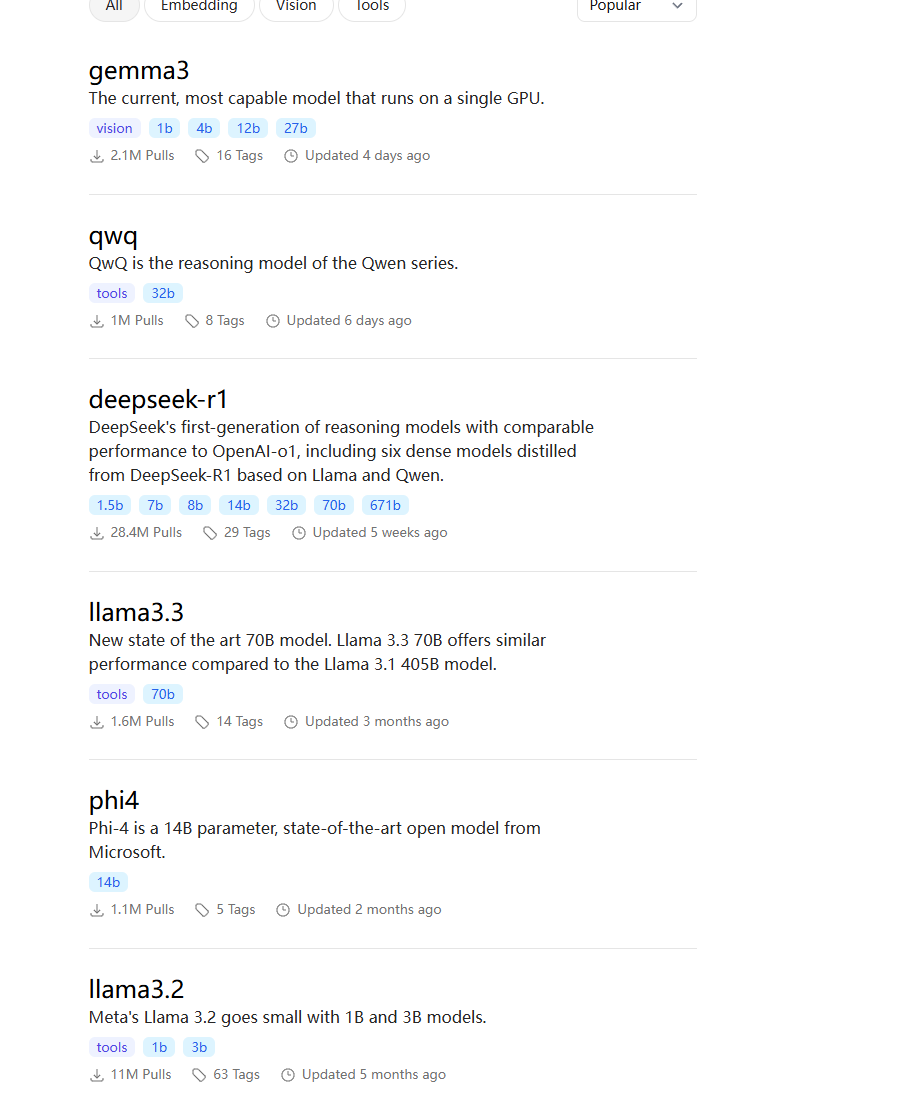

Ollama 支持的大语言模型,包括但不仅限于:llama、deepseek、qwen2.5 。

更多大语言模型,可在 Ollama 官网获取。

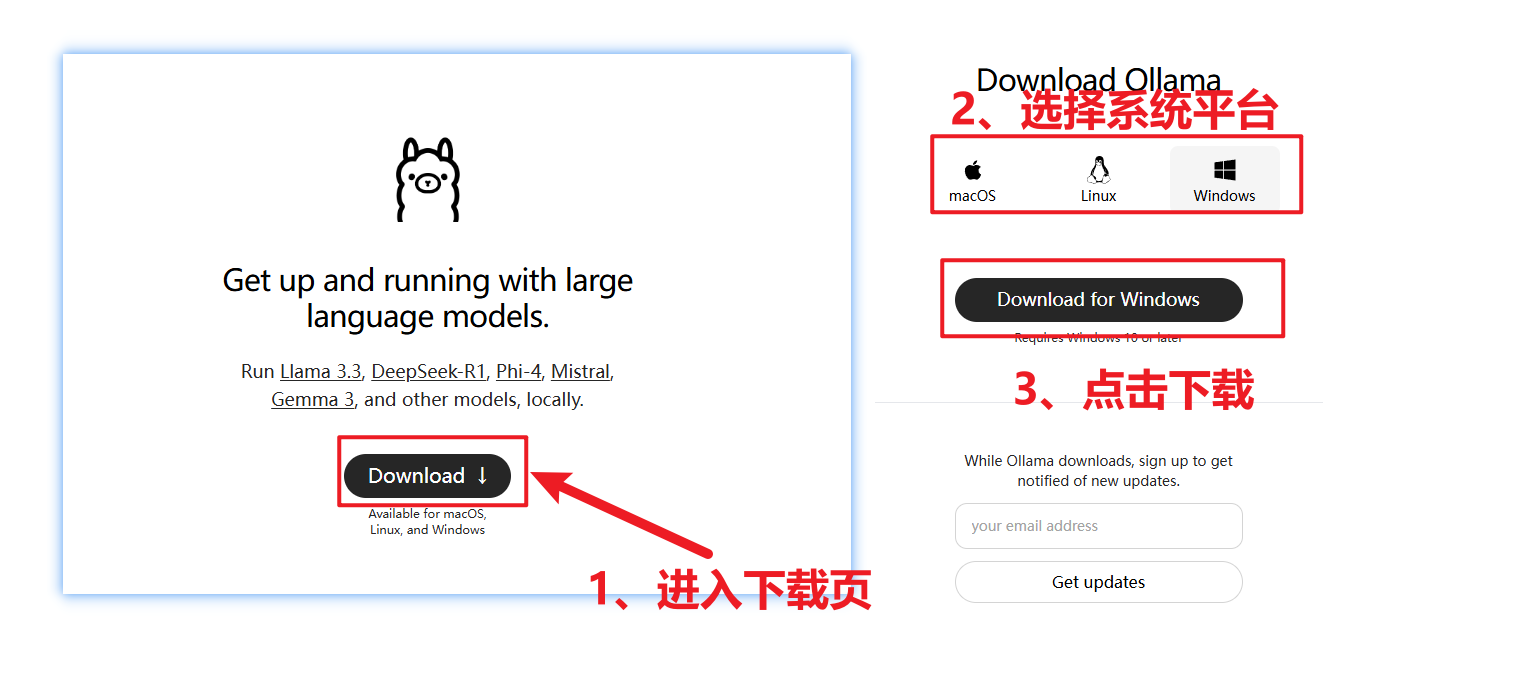

二、Ollama 安装

Ollama 的安装很简单,

下载后,双击 OllamaSetup.exe ,安装即可。

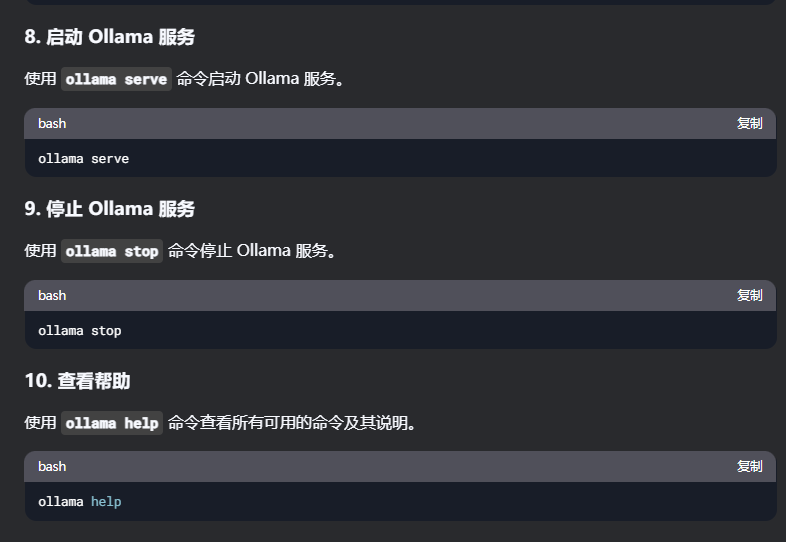

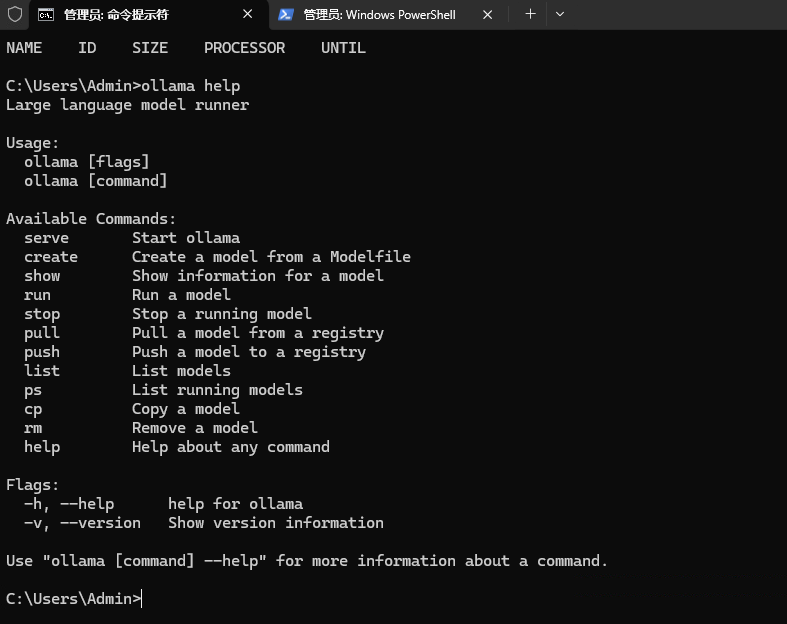

二、Ollama 命令行简介

关于 Ollama 的操作命令可以直接在命令行中查看,也可以直接问在线版的 DeepSeek 。

譬如,你可以直接问 DeepSeek :我想使用 Ollama ,但是不知道 Ollama 命令行怎么使用,可以帮我介绍一下 Ollama 的命令吗?

以下是 DeepSeek 给出内容:

尝试使用 ollama help ,查看一下命令帮助。

通过命令行也能得到对应指令的详细介绍。

三、Ollama 安装 DeepSeek 蒸馏版本

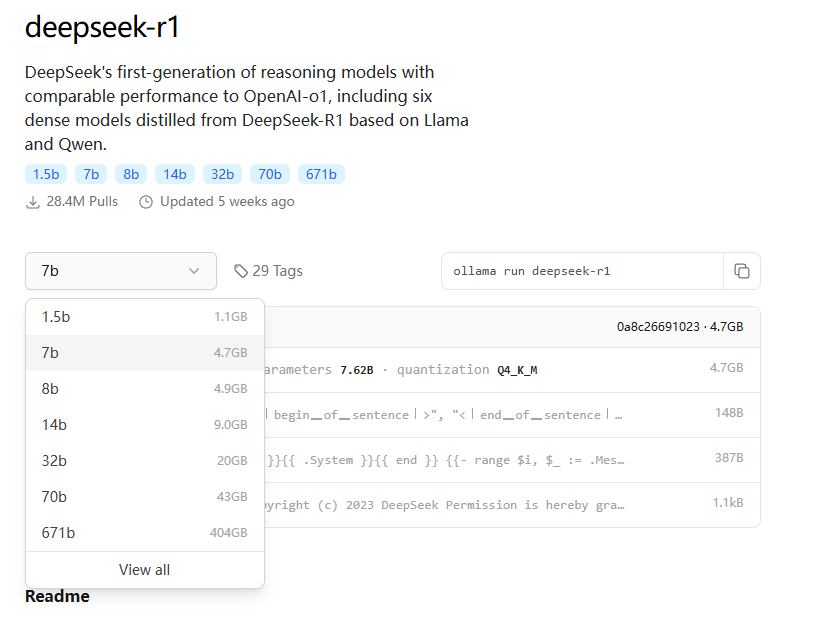

Ollama 针对 DeepSeek R1 有多种不同的版本

分为:1.5b-671b。其中 671b 的就是满血版本的 DeepSeek 。

越高量级的模型,提供的推理能力越强,同样的占用的显存也就越大。

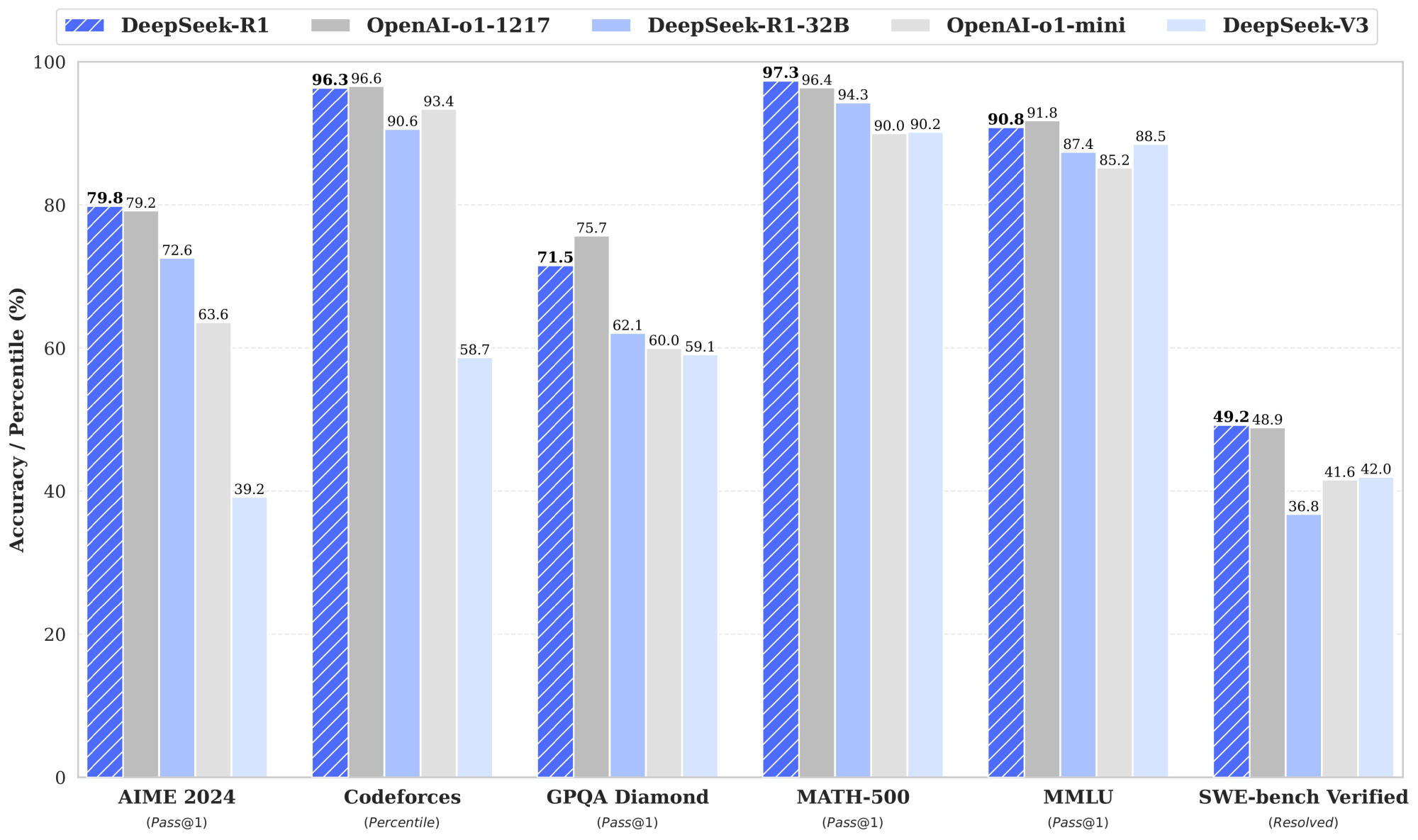

以下是一张,DeepSeek 和 OpenAI o1 的对比图,开源的 DeepSeek-R1 已经可以对标闭源的 OpenAI-o1 。

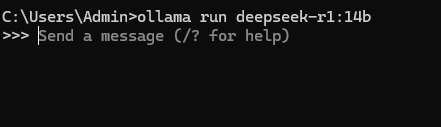

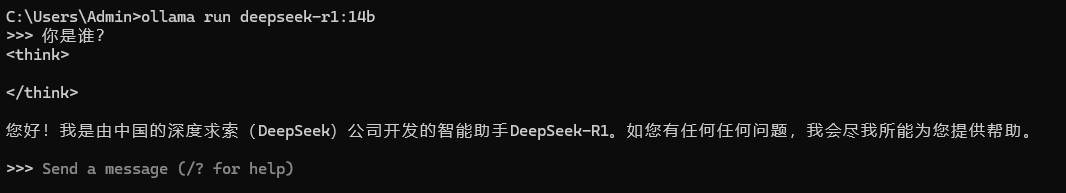

以 DeepSeek 14b 为例,演示安装 ,直接运行命令即可

ollama run deepseek-r1:14b当本地不存在 deepseek-r1:14b 模型时,ollama 进行模型下载,然后在运行 ,运行后的效果图如下,即表示运行成功

测试 DeepSeek ,直接提问:你是谁?

至此,本地版本 DeepSeek 部署完成。

.png)